数据治理解决方案 构建高效、合规的数据处理体系

在数字化浪潮席卷全球的今天,数据已成为企业最核心的资产之一。海量数据的涌现也带来了前所未有的挑战:数据孤岛、质量参差不齐、安全风险以及合规压力。一个系统化的数据治理解决方案,尤其是其核心环节——数据处理,是释放数据价值、驱动智能决策的关键。本文将探讨如何通过专业的数据治理框架,构建一个高效、安全、合规的数据处理体系。

一、 数据治理与数据处理:基石与引擎

数据治理是一套涵盖政策、标准、流程和技术的体系,旨在确保数据的可用性、一致性、完整性、安全性和合规性。而数据处理,则是这一体系中的“引擎”,负责数据的采集、清洗、转换、整合、存储和应用。没有良好的治理框架,数据处理会陷入混乱;没有高效的数据处理能力,治理目标也无法落地。两者相辅相成,共同构成企业数据能力建设的双轮驱动。

二、 数据处理的核心挑战与治理需求

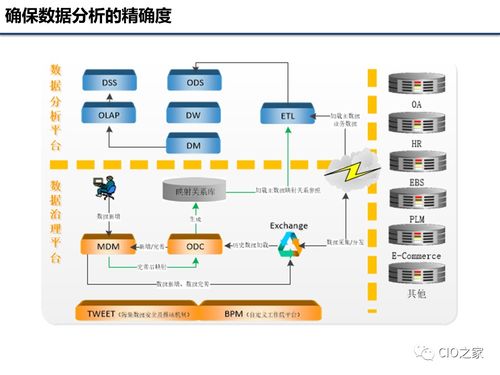

- 数据质量黑洞:原始数据常存在重复、错误、格式不一致等问题,直接影响分析结果的准确性。治理解决方案需建立贯穿采集、清洗、校验全流程的质量监控规则。

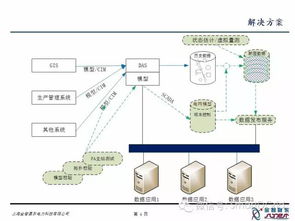

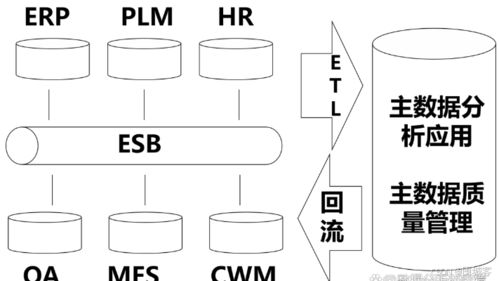

- 数据孤岛与整合难题:数据分散在不同系统、部门,格式与标准不一。治理方案需制定统一的数据标准与模型,并借助ETL(抽取、转换、加载)、数据仓库或数据湖技术进行有效整合。

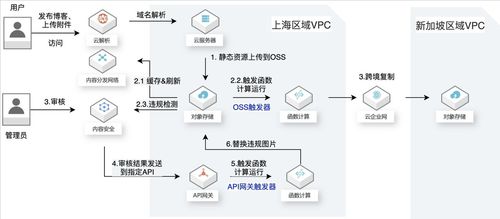

- 安全与合规风险:随着《数据安全法》、《个人信息保护法》等法规出台,数据处理必须在严格的安全边界和合规框架内进行。治理方案需涵盖数据分类分级、访问控制、加密脱敏、审计追踪等关键环节。

- 效率与成本压力:面对海量实时数据,传统处理方式效率低下、成本高昂。治理方案需引入自动化工具与高性能处理平台,优化资源利用。

三、 构建以治理为导向的数据处理解决方案

一个完整的数据治理解决方案,其数据处理部分应包含以下关键模块:

- 数据采集与接入层:

- 支持多源异构数据的实时/批量采集,包括数据库、日志、API、物联网设备等。

- 遵循治理策略中定义的数据源认证与接入标准。

- 数据质量管控中心:

- 定义可配置的质量规则(完整性、准确性、唯一性、时效性等)。

- 实施自动化的数据探查、清洗、标准化与质量稽核。

- 建立质量问题的发现、告警、分派与闭环修复流程。

- 数据整合与开发层:

- 基于统一的数据模型(如主题域模型)进行数据整合与关联。

- 提供可视化的ETL/ELT开发工具,降低技术门槛。

- 构建标准化的数据服务(APIs),支撑上层应用。

- 数据安全与合规引擎:

- 实施数据分类分级,并自动打标。

- 集成动态访问控制、字段级加密、数据脱敏(静态与动态)技术。

- 记录完整的数据血缘与操作日志,满足审计与合规举证要求。

- 元数据与血缘管理:

- 自动采集并管理技术元数据、业务元数据与操作元数据。

- 可视化展现端到端的数据血缘关系,实现影响分析与根因追溯。

- 统一调度与运维监控:

- 对数据处理任务进行统一编排与调度。

- 监控任务执行状态、资源消耗与性能指标,保障处理效率与稳定性。

四、 实施路径与成功要素

- 顶层设计与分步实施:首先明确治理目标,制定顶层策略与路线图,然后从高价值、易见效的业务场景(如客户数据、财务数据)入手,快速试点,迭代推广。

- 组织与文化保障:建立跨部门的数据治理委员会,明确数据所有者、管理员等角色职责,并培育全员的数据责任意识与数据文化。

- 技术平台选型:选择兼具灵活性、扩展性与安全性的数据治理与处理平台,避免形成新的技术孤岛。云原生架构已成为重要趋势。

- 持续度量与优化:建立数据治理成熟度与数据处理效率的度量体系(如数据质量得分、任务准时率),持续监测并优化流程。

五、

在数据驱动的时代,卓越的数据处理能力不再是锦上添花,而是企业生存与竞争的核心。通过构建一个以治理为纲、以处理为目、纲举目张的解决方案,企业能够将原始数据有效转化为可信、可用、有价值的战略资产,从而在洞察市场、优化运营、创新服务、管控风险等方面获得决定性优势。投资于数据治理与数据处理,就是投资于未来。

如若转载,请注明出处:http://www.smxlzj.com/product/66.html

更新时间:2026-01-13 14:13:38